Google Gemini 3 oder Google AI Studio erklärt: Warum Googles KI nicht überall drin ist, wo sie so aussieht – und weshalb Nutzer oft nicht wissen, mit welcher KI sie gerade arbeiten

Google bewirbt „Gemini“ als seine zentrale KI-Plattform, als Antwort auf ChatGPT, Copilot und Co. Der Name taucht in immer mehr Kontexten auf: in der Google-Suche, in Workspace-Anwendungen, in Chat-Interfaces, in Entwicklerumgebungen und zunehmend auch in extern wirkenden Web-Oberflächen. Für Nutzer entsteht der Eindruck eines einheitlichen, klar definierten KI-Produkts. Genau dieser Eindruck ist trügerisch.

Denn Gemini – und insbesondere das, was landläufig als „Gemini 3“ wahrgenommen wird – ist kein eindeutig abgegrenztes Produkt, sondern ein Sammelbegriff für Modelle, Anwendungen und experimentelle Umgebungen, die Google selbst nur unzureichend voneinander trennt. Das führt dazu, dass Nutzer oft nicht mehr nachvollziehen können, wo sie sich gerade befinden, welche KI im Hintergrund arbeitet und wie verlässlich deren Aussagen sind.

Ein Markenname, drei Realitätsebenen

Um das Problem zu verstehen, muss man zwischen drei Ebenen unterscheiden, die Google kommunikativ weitgehend vermischt.

Erstens gibt es die Gemini-Modelle selbst. Das sind die eigentlichen Sprach- und Multimodalmodelle, vergleichbar mit GPT-4 oder Claude. Diese Modelle existieren in verschiedenen Generationen, Ausbaustufen und Konfigurationen. „Gemini 3“ ist in diesem Zusammenhang kein sauber dokumentierter Endnutzerstandard, sondern eine interne oder marketinggetriebene Bezeichnung für eine Modellgeneration.

Zweitens existieren produktisierte Gemini-Anwendungen. Dazu gehören etwa der Gemini-Chat in Googles Benutzeroberfläche oder KI-Funktionen, die direkt in Google Workspace integriert sind. Diese Produkte unterliegen bestimmten Regeln: Sie haben Guardrails, Nutzungsbedingungen, Funktionsgrenzen und zumindest implizit den Anspruch, reale Systeme korrekt abzubilden.

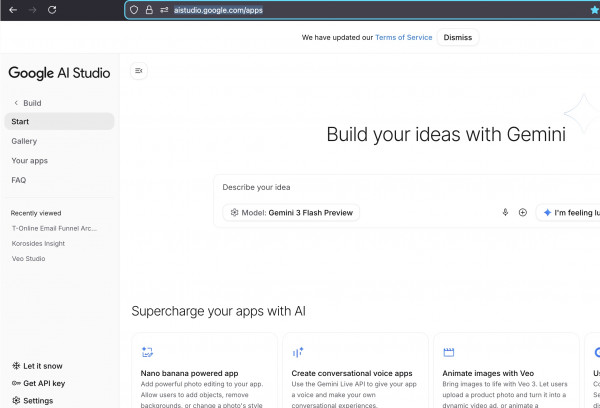

Drittens – und hier liegt der Kern des Problems – gibt es Google AI Studio. Diese Umgebung ist kein Endnutzerprodukt, sondern ein Playground für Entwickler, Demos und Experimente. Sie erlaubt es, Gemini-Modelle zu prompten, mit ihnen Anwendungen zu bauen und Ergebnisse visuell aufzubereiten. AI Studio ist bewusst offen, flexibel und experimentell – aber genau das wird nach außen nicht klar genug kommuniziert.

Google AI Studio: Gemini ohne Sicherheitsnetz

Im Google AI Studio laufen Gemini-Modelle ohne die Schutzmechanismen klassischer Produkte. Es gibt keine verpflichtende Faktenprüfung, keine Validierung externer Systeme, keine Garantie, dass beschriebene Funktionen tatsächlich existieren. Die KI darf hier das tun, was große Sprachmodelle besonders gut können: logisch plausible, gut formulierte Systeme entwerfen.

Das Problem beginnt dort, wo diese Systeme wie reale Produktanleitungen aussehen. Wenn eine im AI Studio erzeugte Anwendung Schritt-für-Schritt-Anleitungen mit Menüpunkten, Klickpfaden und Funktionsbeschreibungen ausgibt, entsteht beim Nutzer der Eindruck, es handele sich um eine reale, getestete Lösung. Tatsächlich ist es oft nur eine synthetische Simulation, zusammengesetzt aus allgemeinem Wissen über ähnliche Systeme.

Der Unterschied ist für den Nutzer nicht erkennbar. Weder die Oberfläche noch die Sprache machen deutlich: Achtung, das hier ist eine hypothetische Konstruktion.

Weiterleitungen, Einbettungen und der Verlust der Orientierung

Verstärkt wird dieses Problem durch Googles zunehmende Nutzung von Weiterleitungen, eingebetteten Apps und Drive-basierten Oberflächen. Ein Nutzer klickt auf einen Google-Link, landet auf einer Seite mit Google-Branding, sauberem Design und vertrauter UX – und geht selbstverständlich davon aus, sich weiterhin in einem konsistenten Google-Produkt zu befinden.

Tatsächlich kann er längst in einer experimentellen AI-Studio-App gelandet sein. Der Übergang ist fließend, visuell kaum markiert und inhaltlich nicht erklärt. Die entscheidende Frage – arbeite ich hier mit einem produktiven Gemini-System oder mit einer Demo? – bleibt unbeantwortet.

Das ist kein Randproblem, sondern ein strukturelles. Denn je stärker Google seine KI-Systeme über verschiedene Kontexte hinweg ausrollt, desto größer wird die Gefahr, dass Produktautorität simuliert wird, ohne tatsächlich vorzuliegen.

Wie die KI in diesem Umfeld arbeitet

Aus Sicht der KI ist das Verhalten nachvollziehbar. Ein Gemini-Modell kennt zahllose E-Mail-Systeme, Automatisierungstools und CRM-Logiken. Es weiß, dass viele Maildienste Filterregeln, Auto-Responder und Funnel-Mechaniken besitzen. Wird es aufgefordert, einen „E-Mail-Funnel für T-Online“ zu bauen, kombiniert es dieses Wissen zu einer schlüssigen, aber nicht überprüften Lösung.

Die KI kann dabei nicht selbst erkennen, dass T-Online Mail diese Funktionen nie besessen hat. Sie extrapoliert aus ähnlichen Systemen. Ohne externe Validierung entsteht so eine funktionale Fiktion, die sprachlich und strukturell vollkommen überzeugend wirkt.

Das eigentliche Versagen liegt daher nicht primär beim Modell, sondern bei der Plattform, die keine klare Trennung zwischen Idee, Simulation und Realität vornimmt.

Warum „Gemini 3“ für Nutzer kein verlässlicher Bezugspunkt ist

Vor diesem Hintergrund wird verständlich, warum die Frage „Bin ich hier in Gemini 3?“ kaum eindeutig zu beantworten ist. Der Nutzer interagiert zwar mit einem Gemini-Modell, aber nicht mit Gemini als Produkt. Die Versionsnummer suggeriert Stabilität, Verlässlichkeit und Vergleichbarkeit – Eigenschaften, die in einer offenen Entwicklungsumgebung nicht gelten.

Google nutzt den Namen „Gemini“ als Dachmarke. Doch was als Vereinfachung gedacht ist, führt in der Praxis zu Intransparenz. Modell, Produkt und Experiment tragen denselben Namen, unterscheiden sich aber fundamental in ihrer Aussagekraft.

Ein strukturelles Kommunikationsproblem

Der Fall zeigt ein zentrales Dilemma moderner KI-Plattformen. Je leistungsfähiger und überzeugender KI-Systeme werden, desto wichtiger wird die klare Kennzeichnung ihres Status. Ist etwas eine getestete Funktion oder nur eine generierte Idee? Ist es Produktrealität oder Modellfantasie?

Google beantwortet diese Fragen bislang nicht ausreichend. Stattdessen entsteht ein Graubereich, in dem Nutzer reale Entscheidungen auf Basis von scheinbar autoritativen, tatsächlich aber ungeprüften KI-Ausgaben treffen.

Fazit: Wenn die Oberfläche mehr verspricht als das System hält

Gemini 3 ist bei Google kein klar umrissenes Produkt, sondern Teil eines vielschichtigen, schwer durchschaubaren KI-Ökosystems. Google AI Studio nutzt Gemini-Modelle, ohne sie in produktive Verantwortung zu nehmen. Die Folge sind Anwendungen und Anleitungen, die überzeugend aussehen, aber keinen Anspruch auf technische Richtigkeit haben.

Für Nutzer bedeutet das: Je professioneller eine KI-Oberfläche wirkt, desto kritischer sollte man fragen, in welchem Kontext sie entsteht. Und für Google bedeutet es eine wachsende Verantwortung, die Grenzen zwischen Produkt, Demo und Experiment klarer zu ziehen. Denn Vertrauen entsteht nicht durch Design – sondern durch Transparenz.